sexta-feira, 21 de setembro de 2012

segunda-feira, 9 de julho de 2012

Internet pela rede elétrica. Como é que isso funciona ?

Internet via rede elétrica: mais barata e prática, mas ainda restrita.

Faz tempo que ouço falar nisso, mas até agora nunca vi nenhuma operadora oferecendo o serviço comercialmente. Um amigo, o Victor, até me pediu para comentar sobre isso aqui no Física sem Neura. Agora, depois de um tempão, resolvi verificar como está esta tecnologia e pude constatar que ainda não decolou, e pelo jeito não decola mais não. Mas isso é minha opinião, Vamos recordar e voltar lá em 2007. Era isso o que se sabia sobre o assunto naquela época:

"ENTENDENDO A INTERNET SOB REDE ELÉTRICA: Publicado no http://www.hardware.com.br, em 15/mar/2007 por Júlio César Bessa Monqueiro.

Uma nova onda de conexão está vindo aí. Ela é a tão discutida Internet

sob rede elétrica, conhecida mundialmente pelo nome BPL - Broadband over

Power Lines, ou PLC - Power Line Communications. Como resume a própria

Wikipedia, "ela consiste em transmitir dados e voz em banda larga

pela rede de energia elétrica. Como utiliza uma infra-estrutura já

disponível, não necessita de obras em uma edificação para ser

implantada". Basicamente, a internet sob rede elétrica é o

encaminhamento do respectivo sinal no mesmo fio da energia elétrica,

cada um na sua frequência.

Embora tenha ouvido se falar muito desta tecnologia em meados do ano 2000, no Brasil houve uma grande época que ela não passou dos testes. Em 2001 houve com a Copel (Companhia Paranaense de Eletricidade) e, logo depois, a Cemig (Companhia Energética de Minas Gerais) e a Eletropaulo (Eletricidade de São Paulo) também anunciaram testes em tal ano. Porém, depois disto, além de testes e mais testes pelas companhias, a próxima notícia que tivemos sobre o PLC no Brasil foi em 21/12/2006, quando foi publicada a notícia da inauguração de uma pequena rede em Porto Alegre, Rio Grande do Sul:

"Dados, imagem, voz e vídeo vão trafegar a uma velocidade de 45 megabits por segundo pela rede elétrica da CEEE. O prefeito José Fogaça inaugura o primeiro ponto de acesso à Internet pela rede elétrica às 16h30, no Centro Administrativo Regional Extremo-Sul (Rua Antônio Rocha Meireles Leite, 50 - Restinga).

Com mais de 3,5 quilômetros de extensão, a Rede PLC da Restinga será a maior em extensão do país, em média e baixa tensões, para fins de inclusão social. Nesta primeira etapa, serão conectados à rede de alta velocidade o posto de saúde Macedônia, a Escola Municipal Alberto Pasqualini e o posto local do Serviço Nacional de Aprendizagem Industrial (AEP Senai)." (http://www2.portoalegre.rs.gov.br/cs/default.php?reg=69748&p_secao=3&di=2006-12-21)

Como vemos acima, a rede atinge somente a extensão de 3,5 quilômetros, algo relativamente curto em termos de Internet massiva. A partir de 2007 aproximadamente, várias empresas começaram a investir no segmento, e em 2008 entrou na discussão de um sinal verde por parte da Anatel e Aneel. Pois bem, em abril a Anatel aprovou, e em agosto a Aneel.

Com a aprovação, as redes usadas para a distribuição de energia elétrica ficam liberadas para a transmissão de serviços de Internet banda larga, sem que isso prejudique a primeira. Assim como a Anatel já fez, a Aneel aprovou a proposta de regulamentação, permitindo então com que as distribuidoras de energia elétrica, como a EDP Bandeirante, Eletropaulo, Cemig e tantas outras por aí, forneçam o serviço através o uso da tecnologia PLC - Power Line Comunication.

A distribuidora de energia terá a liberdade para o "uso privativo da tecnologia PLC", tanto em atividades de distribuição de energia, quanto em aplicações para fins científicos ou comerciais em projetos sociais. Já para uso para fins comerciais, as companhias deverão seguir estritamente as regras previstas em contratos de concessão.

Segundo a nota da própria Aneel, "o emprego da tecnologia possibilita novos usos para as redes de distribuição de energia elétrica, sem que haja necessidade de expansão ou adequação da infra-estrutura já existente. A economia representa a redução de custos aos consumidores que serão beneficiados com a apropriação de parte dos lucros adicionais obtidos por meio da cessão das instalações de distribuição, em benefício da modicidade das tarifas. A Agência prevê que a apuração da receita obtida pelas concessionárias de energia com o aluguel dos fios para as empresas de internet será revertida para a redução de tarifas de eletricidade." O texto ainda diz que "a regulamentação delimita o uso das redes elétricas de distribuição para fins de telecomunicações, garantindo a qualidade, confiabilidade e adequada prestação dos serviços de energia elétrica, gerando incentivos econômicos ao compartilhamento do sistema e zelando pela modicidade tarifária."

Várias concessionárias de eletricidade vêm demonstrando o uso da tecnologia, e algumas inclusive já começaram a implantar testes em larga escala: em abril, "trezentos moradores de Santo Antônio da Platina (Norte Pioneiro) começam a testar, no próximo dia 25, uma tecnologia que poderá causar algum desconforto às provedoras de internet a partir de 2010 - e, nos anos seguintes, provocar dores de cabeça ainda mais agudas às operadoras de telefonia fixa. Quem pretende causar todo esse mal-estar, abocanhando parte do mercado das tradicionais empresas de "telecom", é a Companhia Paranaense de Energia (Copel). A estatal quer fornecer internet de banda "extralarga" e telefonia fixa a seus clientes por meio de uma estrutura que domina há décadas: a rede elétrica. E a preços competitivos." (Fonte: Gazeta do Povo)

Uma das grandes desvantagens desse tipo de tecnologia é principalmente esse: o sinal acaba se corrompendo em distâncias muito longas, de acordo com os seguintes problemas:

Embora tenha ouvido se falar muito desta tecnologia em meados do ano 2000, no Brasil houve uma grande época que ela não passou dos testes. Em 2001 houve com a Copel (Companhia Paranaense de Eletricidade) e, logo depois, a Cemig (Companhia Energética de Minas Gerais) e a Eletropaulo (Eletricidade de São Paulo) também anunciaram testes em tal ano. Porém, depois disto, além de testes e mais testes pelas companhias, a próxima notícia que tivemos sobre o PLC no Brasil foi em 21/12/2006, quando foi publicada a notícia da inauguração de uma pequena rede em Porto Alegre, Rio Grande do Sul:

"Dados, imagem, voz e vídeo vão trafegar a uma velocidade de 45 megabits por segundo pela rede elétrica da CEEE. O prefeito José Fogaça inaugura o primeiro ponto de acesso à Internet pela rede elétrica às 16h30, no Centro Administrativo Regional Extremo-Sul (Rua Antônio Rocha Meireles Leite, 50 - Restinga).

Com mais de 3,5 quilômetros de extensão, a Rede PLC da Restinga será a maior em extensão do país, em média e baixa tensões, para fins de inclusão social. Nesta primeira etapa, serão conectados à rede de alta velocidade o posto de saúde Macedônia, a Escola Municipal Alberto Pasqualini e o posto local do Serviço Nacional de Aprendizagem Industrial (AEP Senai)." (http://www2.portoalegre.rs.gov.br/cs/default.php?reg=69748&p_secao=3&di=2006-12-21)

Como vemos acima, a rede atinge somente a extensão de 3,5 quilômetros, algo relativamente curto em termos de Internet massiva. A partir de 2007 aproximadamente, várias empresas começaram a investir no segmento, e em 2008 entrou na discussão de um sinal verde por parte da Anatel e Aneel. Pois bem, em abril a Anatel aprovou, e em agosto a Aneel.

Com a aprovação, as redes usadas para a distribuição de energia elétrica ficam liberadas para a transmissão de serviços de Internet banda larga, sem que isso prejudique a primeira. Assim como a Anatel já fez, a Aneel aprovou a proposta de regulamentação, permitindo então com que as distribuidoras de energia elétrica, como a EDP Bandeirante, Eletropaulo, Cemig e tantas outras por aí, forneçam o serviço através o uso da tecnologia PLC - Power Line Comunication.

A distribuidora de energia terá a liberdade para o "uso privativo da tecnologia PLC", tanto em atividades de distribuição de energia, quanto em aplicações para fins científicos ou comerciais em projetos sociais. Já para uso para fins comerciais, as companhias deverão seguir estritamente as regras previstas em contratos de concessão.

Segundo a nota da própria Aneel, "o emprego da tecnologia possibilita novos usos para as redes de distribuição de energia elétrica, sem que haja necessidade de expansão ou adequação da infra-estrutura já existente. A economia representa a redução de custos aos consumidores que serão beneficiados com a apropriação de parte dos lucros adicionais obtidos por meio da cessão das instalações de distribuição, em benefício da modicidade das tarifas. A Agência prevê que a apuração da receita obtida pelas concessionárias de energia com o aluguel dos fios para as empresas de internet será revertida para a redução de tarifas de eletricidade." O texto ainda diz que "a regulamentação delimita o uso das redes elétricas de distribuição para fins de telecomunicações, garantindo a qualidade, confiabilidade e adequada prestação dos serviços de energia elétrica, gerando incentivos econômicos ao compartilhamento do sistema e zelando pela modicidade tarifária."

Várias concessionárias de eletricidade vêm demonstrando o uso da tecnologia, e algumas inclusive já começaram a implantar testes em larga escala: em abril, "trezentos moradores de Santo Antônio da Platina (Norte Pioneiro) começam a testar, no próximo dia 25, uma tecnologia que poderá causar algum desconforto às provedoras de internet a partir de 2010 - e, nos anos seguintes, provocar dores de cabeça ainda mais agudas às operadoras de telefonia fixa. Quem pretende causar todo esse mal-estar, abocanhando parte do mercado das tradicionais empresas de "telecom", é a Companhia Paranaense de Energia (Copel). A estatal quer fornecer internet de banda "extralarga" e telefonia fixa a seus clientes por meio de uma estrutura que domina há décadas: a rede elétrica. E a preços competitivos." (Fonte: Gazeta do Povo)

Uma das grandes desvantagens desse tipo de tecnologia é principalmente esse: o sinal acaba se corrompendo em distâncias muito longas, de acordo com os seguintes problemas:

- Manter a alta velocidade com longas distâncias, pelo encapamento plástico "roubar" os sinais de alta frequência;

- Os fios de cobre com tal frequência podem interferir em alguns equipamentos eletro-eletrônicos, por fazer com que os dados gerem ruído no espectro eletromagnético, além de haver possibilidade de corromper os dados pela captura do sinal de rádios e outros;

- Da mesma forma, alguns aparelhos podem interferir na transmissão;

- Emendas, "T"s, filtros de linha, transformadores, e o ligamento e desligamento de eletrônicos na rede elétrica causam ecos do sinal, por criar pontos de reflexão, com isso podendo haver corrupção dos dados;

- Necessidade de instalação de "repetidores" (veremos seu funcionamento mais adiante) em cada tranformador externo (aqueles dos postes), pois filtram sinais de alta frequência.

Esses são os problemas encontrados para o uso do PLC, e analisaremos ao

longo do texto. Uma falta de investimentos por parte do governo federal

também ajuda neste quesito. Há ainda muitas críticas de radioamadores

quanto a interferência junto aos sinais dos transmissores.

Porém, vamos mostrar agora para as vantagens. Entre elas, estão a facilidade de implantação pois, a rede elétrica é a mais abrangente em todos os países, e cobre 95% da população nacional. E não apenas isso, reduz os gastos com implantação de infraestrutura independente, gerando alta economia. isso também gera praticidade, pois bastaria ligar um equipamento como esse na tomada, conectando o cabo de rede em seguida:

Porém, vamos mostrar agora para as vantagens. Entre elas, estão a facilidade de implantação pois, a rede elétrica é a mais abrangente em todos os países, e cobre 95% da população nacional. E não apenas isso, reduz os gastos com implantação de infraestrutura independente, gerando alta economia. isso também gera praticidade, pois bastaria ligar um equipamento como esse na tomada, conectando o cabo de rede em seguida:

Outro ponto importante é a alta taxa de transmissão podendo chegar a até

40Mbps nas freqüências de 1,7MHz a 30MHz. A segurança também é um ponto

importante: ao contrário da rede Wi-Fi, onde um usuário pode tentar se

aproveitar do sinal do próximo, no PLC quem compartilha do mesmo

"relógio", não tem como compartilhar a conexão de rede, devido à

criptografia com algoritmo DES de 56 bits.

Os eletrodomésticos podem também usar uma rede doméstica, com dispositivos Ethernet, USB, wireless ou ponte de áudio, esta conectando o computador às caixas de som, bastando comprar módulos PLC que inclusive já estão à venda, como o mostrado na figura acima.

Passando para o lado mais operacional da coisa, temos o uso dos grids inteligentes. Estes têm a função de monitorar toda a extensão da fiação de energia elétrica, reduzindo perdas na transmissão de energia, gerando também perdas em termos econômicos, já que indústrias e comércios também acabam sendo prejudicados pela manutenção lenta, pois o sistema atual se baseia na informação dos clientes - que após relatarem por telefone a queima de um transformador, por exemplo, esperam até a companhia enviar uma equipe.

Com o grid inteligente, as quedas são reduzidas em 80%, bem como diminuir a energia perdida em 10%, pois, num corte, por exemplo, o grid já aciona automaticamente a central e informa o local do ocorrido.

Além disso, pode ser oferecido um desconto para usuários que não utilizarem o serviço em horário de pico, por exemplo - já que o grid informa à central de forma instantânea todos os dados. Por isso, esta tecnologia dispensa o uso de coletores de informações, aqueles que vão de porta-em-porta. Neste caso também há um envio automático dos dados à central.

"A nossa posição é parecida com a do DSL no final dos anos 90: as pessoas ouviram falar da tecnologia e, ainda que não estejamos tão presentes na vida dos clientes, agora estamos disponíveis", disse Ralph Vogel, porta-voz da Utility.net, uma integradora de BPL baseada em Los Angeles, à IDG Now!.

Iniciativa gigante é a que está sendo feita pela União Europeia. Ela aprovou, em 2007, 9,06 milhões de Euros para apoiar o PLC, desenvolvida pela Opera (Open PLC European Research Alliance), uma aliança determinada a criar novas gerações de tecnologias para redes integradas, e, todo o projeto é co-financiado pela União Européia, beneficiando vários países da Europa - e inclusive outros, por tabela, já que a tecnologia nunca fica num local só. Neste caso foi criado uma rede com especificação DS2, de 200Mbps, para o PLC (ou BPL). A equipe do Opera centralizará o BPL em programas de Internet banda larga, ensino virtual, telefonia VoiP, entre outros serviços inteligentes, e vídeo. A iniciativa teve participação de 26 sócios de 11 países, com a Espanha na liderança.

Os eletrodomésticos podem também usar uma rede doméstica, com dispositivos Ethernet, USB, wireless ou ponte de áudio, esta conectando o computador às caixas de som, bastando comprar módulos PLC que inclusive já estão à venda, como o mostrado na figura acima.

Passando para o lado mais operacional da coisa, temos o uso dos grids inteligentes. Estes têm a função de monitorar toda a extensão da fiação de energia elétrica, reduzindo perdas na transmissão de energia, gerando também perdas em termos econômicos, já que indústrias e comércios também acabam sendo prejudicados pela manutenção lenta, pois o sistema atual se baseia na informação dos clientes - que após relatarem por telefone a queima de um transformador, por exemplo, esperam até a companhia enviar uma equipe.

Com o grid inteligente, as quedas são reduzidas em 80%, bem como diminuir a energia perdida em 10%, pois, num corte, por exemplo, o grid já aciona automaticamente a central e informa o local do ocorrido.

Além disso, pode ser oferecido um desconto para usuários que não utilizarem o serviço em horário de pico, por exemplo - já que o grid informa à central de forma instantânea todos os dados. Por isso, esta tecnologia dispensa o uso de coletores de informações, aqueles que vão de porta-em-porta. Neste caso também há um envio automático dos dados à central.

"A nossa posição é parecida com a do DSL no final dos anos 90: as pessoas ouviram falar da tecnologia e, ainda que não estejamos tão presentes na vida dos clientes, agora estamos disponíveis", disse Ralph Vogel, porta-voz da Utility.net, uma integradora de BPL baseada em Los Angeles, à IDG Now!.

Iniciativa gigante é a que está sendo feita pela União Europeia. Ela aprovou, em 2007, 9,06 milhões de Euros para apoiar o PLC, desenvolvida pela Opera (Open PLC European Research Alliance), uma aliança determinada a criar novas gerações de tecnologias para redes integradas, e, todo o projeto é co-financiado pela União Européia, beneficiando vários países da Europa - e inclusive outros, por tabela, já que a tecnologia nunca fica num local só. Neste caso foi criado uma rede com especificação DS2, de 200Mbps, para o PLC (ou BPL). A equipe do Opera centralizará o BPL em programas de Internet banda larga, ensino virtual, telefonia VoiP, entre outros serviços inteligentes, e vídeo. A iniciativa teve participação de 26 sócios de 11 países, com a Espanha na liderança.

Funcionamento

O princípio básico de funcionamento das redes PLC é que, como a frequência dos sinais de conexão é na casa dos MHz 91,7 a 30), e a energia elétrica é da ordem dos Hz (50 a 60 Hz), os dois sinais podem conviver harmoniosamente, no mesmo meio. Com isso, mesmo se a energia elétrica não estiver passando no fio naquele momento, o sinal da Internet não será interrompido. A tecnologia, também possibilita a conexão de aparelhos de som e vários outros eletroeletrônicos em rede, como já dito acima. A Internet sob PLC possui velocidade não assíncrona: ou seja, você tem o mesmo desempenho no recebimento ou envio de dados.

O princípio de funcionamento da rede comercial é parecido, vamos ao esquema:

O sinal do BPL sai da central, indo para o injetor, que vai se

encarregar de enviá-lo à rede elétrica. No caminho, o repetidor tem a

função de não deixar com que os transformadores filtrem as altas

frequências. Chegando perto da casa, o extrator, que deixa o sinal

pronta para uso da casa, chegando até o modem BPL, que vai converter

para uso pelo computador, através de uma porta Ethernet ou USB, ou mesmo

via Wi-Fi. No penúltimo passo, no caminho poste-casa, há 3 meios: por

cabo de fibra óptica, por wireless ou pela própria fiação elétrica, este

último mais provável.

Como há um repetidor a cada transformador, e nesse sistema com grids inteligentes não se usa mais os atuais "relógios", descarta-se a desvantagem mais famosa na Internet do uso do PLC - de que os transformadores, por absorver os sinais, impossibilitariam a instalação.

Analisando em termos de cidade, vamos à mais um esquema:

Como há um repetidor a cada transformador, e nesse sistema com grids inteligentes não se usa mais os atuais "relógios", descarta-se a desvantagem mais famosa na Internet do uso do PLC - de que os transformadores, por absorver os sinais, impossibilitariam a instalação.

Analisando em termos de cidade, vamos à mais um esquema:

Veja, que é de modo um pouco diferente do outro, adaptado pela empresa Plexeon (http://www.plexeon.com/),

porém com a mesma definição. O sinal sai da estação que o "injeta" na

linha, indo para a rede de distribuição - primeiramente à órgãos

públicos - e depois às casas, sempre passando por um repetidor ao passo

que um transformador passa na linha, e um extrator quando finalmente

chega na casa. Note que as casas também podem ser conectadas pelo

repetidor.

Para uma rede doméstica apenas, basta ligar um módulo PLC do roteador na rede elétrica, e o do outro computador também, após isso configurando normalmente, como você está habituado a fazer. Esses módulos têm o nome de "USB PowerLine", para ligar na porta USB, ou "Bridge Ethernet 10/100 Mbps Powerline" para ligar diretamente na porta de rede, e é vendido no Brasil por várias empresas, como a Naxos, a Trendnet, Siemens, etc, e pode ser encontrado até no Mercado Livre.

Para uma rede doméstica apenas, basta ligar um módulo PLC do roteador na rede elétrica, e o do outro computador também, após isso configurando normalmente, como você está habituado a fazer. Esses módulos têm o nome de "USB PowerLine", para ligar na porta USB, ou "Bridge Ethernet 10/100 Mbps Powerline" para ligar diretamente na porta de rede, e é vendido no Brasil por várias empresas, como a Naxos, a Trendnet, Siemens, etc, e pode ser encontrado até no Mercado Livre.

Existem ainda adaptadores e roteadores que eliminam completamente os

fios, como os mostrados no esquema da Trendnet, abaixo. Para uma rede

doméstica, existem modens que "injetam" o sinal em sua rede elétrica

residencial, e se você tiver uma placa de rede wireless, há modelos de "Pontos de Acesso Powerline Wireless" que 'capturam' o sinal na tomada mais próxima do computador, e disponibilizam o sinal como um roteador wireless qualquer:

A especificação mais usada hoje é a DS2, que se originou na Europa. Nos EUA, também é usado o padrão HomePlug.

As versões comerciais vendidas no exterior hoje possui velocidade média

de 200 Mbits/s. O principal diferencial entre os padrões é a frequência

- cada uma com suas vantagens. No Brasil, não há ainda padrão definido,

e a tendência é que o japonês, americano e europeu reinem juntas.

Como já visto, o BPL não interfere, na sua frequência, em eletrodomésticos, devido às grandezas serem diferentes. Porém, parte da onda média (1,7 a 3 Mhz) e toda a onda média (3 a 30 Mhz) ficam inutilizadas e prejudicadas, podendo outros equipamentos causarem interferências, como motores e dimmers de luz, além de ecadores de cabelos, aspiradores e as furadeiras elétricas, havendo uma menor possibilidade também dos chuveiros elétricos prejudicarem.

Vale lembrar também que os equipamentos PLC não podem ser ligados à no-breaks, estabilizadores ou filtros de linha, pois este bloqueiam sinais de alta frequência.

Bom, e então, o que será do BPL? Apesar de muitas desvantagens, essa nova tecnologia caminha para o mesmo rumo que o maioria: unificação. Transformar a rede de telefonia (através do VoIP), internet e elétrica numa linha só é mais um passo para a evolução. Com relação às desvantagens, podemos dizer que, assim como a tecnologia ADSL, que leva dois tipos de sinais num só fio (dados e voz), e, as interferências podem ser consertadas ao longo do tempo, com novos equipamentos que respeitem essa faixa de frequência, além de outras tecnologias e padrões internacionais que vão sendo naturalmente incorporadas. Ou seja, a maioria dos problemas enfrentados podem ser resolvidos com uma boa dose de tempo. Claro que, essa teoria só é válida se houver interesse muito grande de empresas e principalmente de governos, além de uma cooperação entre companhias de eletricidade, Internet e telefonia. É como a carroça, que pode demorar, mas chega lá. Porém, ela não vai andar se cavalos não a puxarem, muito menos se cada um quiser ir para um lado :-).

No Brasil, obviamente também pode dar certo, pois muitas empresas do setor de elétrica estão continuando seus testes, além de que tecnologias europeias podem ser importadas, isso se nenhuma universidade brasileira desenvolver algo antes. O BPL se mostra como mais uma alternativa de inclusão à Internet, num país onde 95% da população possui energia elétrica. Além disso, como a infra-estrutura é de menor custo, esse sistema mostra-se como uma alternativa mais econômica para os usuários."

Como já visto, o BPL não interfere, na sua frequência, em eletrodomésticos, devido às grandezas serem diferentes. Porém, parte da onda média (1,7 a 3 Mhz) e toda a onda média (3 a 30 Mhz) ficam inutilizadas e prejudicadas, podendo outros equipamentos causarem interferências, como motores e dimmers de luz, além de ecadores de cabelos, aspiradores e as furadeiras elétricas, havendo uma menor possibilidade também dos chuveiros elétricos prejudicarem.

Vale lembrar também que os equipamentos PLC não podem ser ligados à no-breaks, estabilizadores ou filtros de linha, pois este bloqueiam sinais de alta frequência.

Bom, e então, o que será do BPL? Apesar de muitas desvantagens, essa nova tecnologia caminha para o mesmo rumo que o maioria: unificação. Transformar a rede de telefonia (através do VoIP), internet e elétrica numa linha só é mais um passo para a evolução. Com relação às desvantagens, podemos dizer que, assim como a tecnologia ADSL, que leva dois tipos de sinais num só fio (dados e voz), e, as interferências podem ser consertadas ao longo do tempo, com novos equipamentos que respeitem essa faixa de frequência, além de outras tecnologias e padrões internacionais que vão sendo naturalmente incorporadas. Ou seja, a maioria dos problemas enfrentados podem ser resolvidos com uma boa dose de tempo. Claro que, essa teoria só é válida se houver interesse muito grande de empresas e principalmente de governos, além de uma cooperação entre companhias de eletricidade, Internet e telefonia. É como a carroça, que pode demorar, mas chega lá. Porém, ela não vai andar se cavalos não a puxarem, muito menos se cada um quiser ir para um lado :-).

No Brasil, obviamente também pode dar certo, pois muitas empresas do setor de elétrica estão continuando seus testes, além de que tecnologias europeias podem ser importadas, isso se nenhuma universidade brasileira desenvolver algo antes. O BPL se mostra como mais uma alternativa de inclusão à Internet, num país onde 95% da população possui energia elétrica. Além disso, como a infra-estrutura é de menor custo, esse sistema mostra-se como uma alternativa mais econômica para os usuários."

Isso foi em 2007, dois anos depois, em 2009 aqui no Brasil, a coisa estava assim:

"A Anatel (Agência Nacional de Telecomunicações) homologou em abril a tecnologia de internet pela rede elétrica,

que permite o tráfego de voz, dados e imagens. Conhecida como PLC

(Power Line Communication), a nova forma de acesso à web já existe há

cerca de dez anos e é vendida na Europa a links de 4,5 Mbps —que devem

chegar a 14 Mbps até o final do ano.

No Brasil, o uso começou no Paraná, na fornecedora de energia elétrica local, no final da década passada. Desde então, foi desenvolvida uma tecnologia compatível com o sistema elétrico brasileiro, que foi testado nos últimos dois anos, até ser homologado.

A principal vantagem dessa tecnologia, segundo os especialistas, é que fornecerá acesso à web pela tomada —assim aproveita uma estrutura já existente para chegar a regiões onde outras alternativas de acesso rápido ainda não estão disponíveis. Com o PLC, a tomada elétrica vira o ponto principal de comunicação da residência ou da empresa. Mas, na prática, o que muda para o usuário?

Segundo o engenheiro eletrônico Almir Meira, professor da FIAP e Faculdade Módulo, para ter acesso à tecnologia, o usuário deverá contratar o serviço da operadora credenciada para comercializá-lo e adquirir um modem compatível com a tomada elétrica.

No Brasil, o uso começou no Paraná, na fornecedora de energia elétrica local, no final da década passada. Desde então, foi desenvolvida uma tecnologia compatível com o sistema elétrico brasileiro, que foi testado nos últimos dois anos, até ser homologado.

A principal vantagem dessa tecnologia, segundo os especialistas, é que fornecerá acesso à web pela tomada —assim aproveita uma estrutura já existente para chegar a regiões onde outras alternativas de acesso rápido ainda não estão disponíveis. Com o PLC, a tomada elétrica vira o ponto principal de comunicação da residência ou da empresa. Mas, na prática, o que muda para o usuário?

Segundo o engenheiro eletrônico Almir Meira, professor da FIAP e Faculdade Módulo, para ter acesso à tecnologia, o usuário deverá contratar o serviço da operadora credenciada para comercializá-lo e adquirir um modem compatível com a tomada elétrica.

AES Eletropaulo testa tecnologia (29/7/2009)

AES Eletropaulo testa tecnologia (29/7/2009)A AES Eletropaulo já divulgou que não pretende vender o PLC (Power Line Communication) diretamente para o consumidor final, devendo fazer uma parceria com as operadoras de telecomunicações para atender ao novo serviço, como Telefonica, TIM, Vivo, Oi e Claro. "Elas é que deverão vender diretamente para o consumidor. Esse modem vai filtrar o sinal elétrico e disponibilizar os sinais de voz, dados e imagens em saídas específicas, funcionando como central de mídia", explica.

Em São Paulo, já são três bairros onde esta tecnologia está sendo testada pela AES Eletropaulo: Pinheiros, Cerqueira César e Moema. Para os demais bairros, a tecnologia deverá estar disponível a partir de 2010. Para adaptar a rede elétrica para o PLC, as concessionárias de energia devem instalar uma grande quantidade de repetidores e roteadores junto aos transformadores, para amplificar o sinal de dados e evitar as oscilações nos pontos de segmentação da rede elétrica.

O modem poderá vir com uma antena de rede sem fio para facilitar o uso em notebooks, por exemplo. "Outra possibilidade é portar o modem e usar a sua internet em qualquer lugar, bastando plugá-lo na tomada. Além disso, a montagem das redes vai ser simplificada, não necessitando de cabeamento de dados —que hoje é um problema, devido à dificuldade de passagem dos cabos", explica Meira.

Para as empresas, o PLC pode ser uma tecnologia que irá facilitar a interligação de unidades distantes por meio da rede elétrica, diminuindo a necessidade de links dedicados de dados, que são caros. Em São Paulo, o engenheiro Clinton Namur é uma das pessoas que participaram do teste da internet via rede elétrica. Ele pode acessar a web na cozinha ou, se preferir, também na sala. É só plugar o computador em qualquer tomada da casa. A conexão também ficou mais rápida. "Achei fantástica essa ideia, que eu abracei desde o começo. Para mim está atendendo perfeitamente", diz Namur."

Bom, ainda não vi ninguém comercializando esse milagre, distribuindo sinal de internet via rede elétrica, mas existem boas alternativas para se montar uma rede interna, utilizando a fiação elétrica já disponível na sua casa ou apartamento, quando o WiFi não for suficiente. Veja uma delas:

08/07/2011 12h19, via http://g1.globo.com

- Atualizado em

08/07/2011 12h21

Dispositivo para roteador permite acessar a internet pela rede elétrica

Kit 'Powerline' transforma o circuito elétrico em rede de dados.

Solução dispensa novo cabeamento em casas e apartamentos.

A Unicoba, empresa que atua no mercado tecnologia, apresentou na feira Eletrolar Show 2011 o kit Powerline TP-Link que transforma o circuito elétrico em uma rede de dados através de adaptadores conectados em diferentes tomadas. Ligado a um roteador, fornece acesso a internet em qualquer lugar da residência.

Vendido aos pares, os dispositivos são simples de usar, bastando conectar o primeiro na tomada e ao roteador sem fio, por exemplo. Já a segunda unidade pode ficar em outra tomada de qualquer cômodo ou andar da residência.

O Powerline possui criptografia para garantia a segurança dos dados trafegados e ainda suporta velocidade de até 200 Mbps, suficiente para assistir vídeos em alta definição. Possui, também, o recurso de QoS (Qualidade do Serviço, na sigla em inglês) que garante a largura de banda necessária para aplicações como voz, vídeo e jogos on-line.

Vários dispositivos podem ser beneficiar do recurso, tais como câmeras IP, servidores de impressão e access points. Com lançamento oficial no Brasil previsto para outubro, o produto chegará pelo preço sugerido de R$ 250.

Bom, é isso o que se tem até o momento. Particularmente, eu acho que o futuro próximo da distribuição de sinais de internet, estão nas soluções sem fio. Até a próxima postagem. Valeu pela ideia, Victor. Obrigado !

terça-feira, 8 de maio de 2012

5 invenções que contrariam as Leis da Física.

Por Felipe Arruda

Fonte: http://tecmundo.com.br/

A realidade é mesmo muito estranha. Existe o polônio,

um elemento químico que, apesar de muito letal, pode ser encontrado

naturalmente no meio ambiente. Agora, conheça cinco

invenções ou substâncias mais do que esquisitas. Vamos a elas.

Condutores elásticos

Já existem muitas notícias sobre os “wearable computers”, ou seja,

gadgets ou computadores que podem ser usados como acessórios de moda ou

peças de roupa.

Mas pesquisadores japoneses resolveram levar esse conceito a um

patamar muito maior. A “malha” exibida acima é, na verdade, um material

elástico feito com nanotubos de carbono e capaz de conduzir energia

elétrica por meio de transistores. Com ela seria possível construir

máquinas completamente flexíveis, a ponto de serem esticadas até

dobrarem de tamanho e voltarem ao normal sem que fossem danificadas.

Alumínio transparente

Imagine um material resistente como o aço e transparente como o

vidro. Impossível? Não mais. Apesar de a ideia ter origem em um dos

filmes de Jornada nas Estrelas, o alumínio transparente já é um produto

real e, além disso, muito desejado pela indústria militar.

Em um mundo cada vez mais preocupado com a segurança, a existência de

um alumínio transparente favorece o aparecimento de janelas mais

resistentes a tiros ou grandes impactos, ideais para automóveis e

aviões.

Ferrofluido

Imagine um líquido que pode reagir a campos magnéticos. Bizarro, não?

Mas isso existe e tem o nome de “ferrofluido” ou “fluido magnético”.

Graças às nanopartículas ferromagnéticas de hematita ou magnetita, esse

material pode interagir com ímãs e assumir formas muito curiosas, como

pode ser constatado no vídeo acima.

As aplicações do ferrofluido são bem variadas. Capaz de ser usada

como redutora de atrito, a substância se torna muito conveniente para a

engenharia mecânica. Além disso, a NASA tem estudado o uso do fluido

magnético como base de um sistema de altitude para suas aeronaves.

Ainda, como se não bastasse, a medicina pode usar o líquido como

contraste em exames de ressonância magnética, ajudando, inclusive, na

detecção de câncer.

Aerogel

O aerogel é um material leve

como o ar, mas resistente como o aço. Além disso, a aparência desse

material é tão futurista quanto à do ferrofluido.

Existem diversos usos práticos para o aerogel. A NASA, por exemplo,

já usou o material para capturar partículas de poeira espacial, e o

sólido serve como um ótimo isolante térmico, chegando a ser 39 vezes

mais eficaz do que a melhor fibra de vidro térmica que existe

atualmente.

Fluido não newtoniano

Grosso modo, podemos dizer que um fluido é considerado não newtoniano

quando não tem uma viscosidade bem definida e pode se solidificar ao

ser submetido a uma tensão. Um bom exemplo são aquelas piscinas cheias

de água e amido de milho, usadas em alguns programas de auditório da

televisão. Ao pisar fortemente sobre o líquido, ele se solidifica

momentaneamente e o participante consegue correr sobre a “água”.

A indústria militar pretende usar esse tipo de comportamento em

trajes de combates. A ideia é que a roupa especial seja suave e

confortável durante a maior parte do tempo, mas que se enrijeça

rapidamente ao receber o impacto de uma bala disparada pelo inimigo.

Pensando melhor, essa talvez seja uma boa ideia até mesmo para as

vestimentas civis. Dessa forma, as pessoas ficam mais seguras e, ao

mesmo tempo, continuam na moda.

quarta-feira, 18 de abril de 2012

A morte de Einstein - hoje faz 57 anos.

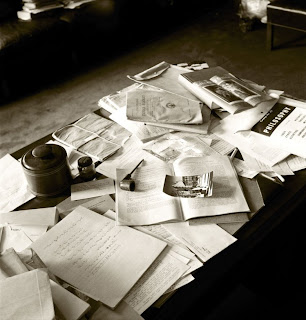

Hoje é o aniversário da morte de Albert Einstein, em 1955. Seu falecimento foi uma grande perda não apenas para a física, mas para toda a academia — e nas horas seguintes à sua morte, o fotógrafo Ralph Morse (Life) tirou fotos do escritório de Einstein em Princeton do jeitinho que ele deixou.

Ele resume belamente aquele homem: uma mesa notavelmente desarrumada, estantes carregadas de livros e, claro, um quadro negro com suas fórmulas matemáticas de alto nível. Morse relembra como as fotos foram feitas à Life:

“Primeiro fui ao hospital mas estava um caos lá — jornalistas, fotógrafos, curiosos. Então fui ao escritório de Einstein [no Instituto de Estudos Avançados]. No caminho, parei e comprei whisky. Eu sabia que as pessoas estariam relutantes em falar, mas que elas geralmente aceitavam alegremente uma garrafa de bebida, mais do que dinheiro, em troca de ajuda. De qualquer forma, entrei no prédio, encontrei o diretor, ofereci-lhe um pouco de whisky e, assim, ele abriu o escritório.”

“Primeiro fui ao hospital mas estava um caos lá — jornalistas, fotógrafos, curiosos. Então fui ao escritório de Einstein [no Instituto de Estudos Avançados]. No caminho, parei e comprei whisky. Eu sabia que as pessoas estariam relutantes em falar, mas que elas geralmente aceitavam alegremente uma garrafa de bebida, mais do que dinheiro, em troca de ajuda. De qualquer forma, entrei no prédio, encontrei o diretor, ofereci-lhe um pouco de whisky e, assim, ele abriu o escritório.”O resultado é uma pertinente lembrança da geniosidade de um homem em um dia que nós todos deveríamos nos lembrar. [Life. Foto: Ralph Morse-Time & Life Pictures/Getty Images]

Por Jamie Condliffe

Fonte da reportagem: http://www.gizmodo.com.br/conteudo/por-dentro-do-escritorio-de-albert-einstein/

terça-feira, 17 de abril de 2012

O que é bom precisa ser compartilhado !

@SidneyPeres obrigado pelos RTs! Ficamos felizes que esteja gostando do conteúdo da Revista Entremundos. :-)

— Revista Entremundos (@reventremundos) abril 17, 2012O smartphone perfeito.

Por Fabio Jordão em 10 de Abril de 2012, via TecMundo

Fonte da reportagem: TecMundo: http://www.tecmundo.com.br/

Ilustração: Homero Meyer | Design: Tim Trauer

Leia mais em: http://www.tecmundo.com.br/infografico/21931-como-seria-o-smartphone-perfeito-infografico-.htm#ixzz1sJxg7psv

"Dezenas de fabricantes, centenas de smartphones. Há modelos para todos os gostos, mas poucos são sonhos de consumo. Entre os mais avançados, alguns são mais finos, outros trazem bateria de duração prolongada e existem até os que têm tecnologia 3D. Eles contam com design atraente e configurações de hardware poderosas.

Mas como seria o smartphone perfeito? A resposta para essa pergunta está atrelada ao gosto de cada um. Todavia, cogitamos que a opinião do coletivo poderia resultar em um dispositivo próximo ao que consideramos como perfeito. Assim, montamos um dispositivo com o que há de mais avançado e com recursos úteis aos usuários mais exigentes.

Um pé na realidade, outro no futuro

A principal ideia de montar um aparelho poderoso é reunir tudo que existe de melhor. Assim, nosso aparelho traz processador quad-core, memória RAM de sobra e até um chip gráfico de oito núcleos. Exagero? Não exatamente. Essa configuração tem alguns dos componentes mais avançados da atualidade, ideais para o smartphone perfeito. Evidentemente, o sistema operacional é o Android Ice Cream Sandwich.

A memória interna de 64 GB parece ser mais do que o necessário, mas considerando a quantidade de apps e jogos de qualidade disponíveis na loja Google Play, essa quantidade acaba sendo pouca para tanta coisa interessante. Isso sem contar os vídeos em Full HD que ocupam muito espaço no dispositivo. Daí a ideia de adicionar o espaço para cartão.

Ilustração: Homero Meyer | Design: Tim Trauer

Leia mais em: http://www.tecmundo.com.br/infografico/21931-como-seria-o-smartphone-perfeito-infografico-.htm#ixzz1sJxg7psv

segunda-feira, 16 de abril de 2012

As mais estranhas partículas pós LHC.

Das mais impressionantes pesquisas sobre o universo, nos últimos tempos, quase todas têm participação de alguma partícula ainda não conhecida pela física, teorizada recentente. Até o Modelo Padrão da Física (teoria criada em 1973 que prevê a existência de partículas como o quark, neutrinos e antineutrinos) já está sendo revisado em vários pontos para incluir novas descobertas.

Para o estudo de questões físicas complicadas, tais como antimatéria, matéria escura e gravitação, os cientistas estão “criando” novas partículas, em um catálogo de constante atualização. Elas seriam satisfatórias para resolver vários problemas da física moderna, mas infelizmente a existência de nenhuma delas foi comprovada na prática. Conheça onze destas partículas:

11 – Stringball

A teoria das cordas prevê que as partículas quânticas, como elétrons e quarks, estão dispostas no universo vibrando como cordas de energia. Esta linha de pensamento, que não vê a partícula como um agente estático sem dimensão, satisfaz o modelo padrão e responde questões como a ação da gravidade em grandes distâncias cósmicas.

Se as partículas de fato vibram como cordas, esta teoria também conceitua algumas anomalias. Uma delas, estudada pelo acelerador de partículas LHC, seria a possível existência de buracos negros em miniatura. Outra seria um momento em que duas partículas abandonam a condição de corda e se chocam uma com a outra, formando o que se chama de “Stringball” (literalmente, “esfera de cordas”), o que deve dar origem a mais dimensões além das três que conhecemos.

O que faria as cordas saírem de seu estado natural e formarem esferas é uma grande quantidade de energia. Dessa maneira, os cientistas teorizam que seria possível criar tais esferas em um dispositivo como o LHC.

10 – Tetraquark

Esta partícula seria basicamente o que diz o nome: um aglomerado de quatro quarks. Em um modelo mais avançado, existiria um “pentaquark”, que inclui na conta um antiquark cujo peso seria a metade de um próton. Um próton, segundo o modelo padrão, é composto por três quarks juntos, ou um quark e um antiquark (proveniente da antimatéria).

Os pesquisadores defendem, contudo, que possam existir agrupamentos maiores de quarks, que superam um próton. A tentativa que chegou mais perto de comprovar sua existência, experimentalmente, aconteceu em 2005, mas falhou.

9 – Glueball

A existência dessa partícula, que ainda não possui tradução específica para o português (seria algo como uma “esfera de glúon”), também se baseia na teoria das cordas. Dentro de um próton, os quarks não são estáveis: a todo momento, são criados e eliminados. Um quark possui carga elétrica negativa, positiva, e uma terceira, hipotética, chamada de “carga de cor”.

Para que os quarks possam se manter juntos em um próton, é preciso haver uma força de atração. Esta força, conforme essa teoria, seria proporcionada porque partículas transitam entre os quarks carregados com a tal carga de cor. Tais partículas, por sua vez, seriam os glúons (cujo nome lembra a ideia de colar, de unir).

Como os glúons também têm carga própria, pesquisadores defendem que eles poderiam se unir por si próprios e compor matéria, formando um novo tipo de partícula. Estas partículas seriam as “glueballs”.

8 – Inflatão

Especialistas em astrofísica debatem intensamente o que teria acontecido logo após o Big Bang. Se uma única explosão foi responsável por criar o universo, como é que ele conseguiu se expandir desse jeito? As teorias mais aceitas propõem que seria necessária uma força de campo energético que espalhou os elementos pelo espaço em uma velocidade superior à da luz. A teoria quântica defende que todo campo está associado a uma partícula. Neste caso, seria o inflatão.

Seguindo a mesma teoria de expansão do universo, o inflatão teria sido responsável por expandir o universo logo após o ponto inicial, mas eventualmente estas partículas seriam dissolvidas em outros tipo de matéria e radiação, até sumir. Com isso, recriar um inflatão demandaria um acelerador de partículas um trilhão de vezes mais potente que o LHC.

7 – Pomerão

Caso as glueballs (partículas originárias dos glúons, que mantêm os quarks unidos) realmente existam, comprová-las na prática é uma tarefa muito difícil, pois exige que se “isole” um momento de atração entre quarks. O mais próximo que se imagina disso é conseguir capturar o instante em que as glueballs são convertidas em pacotes de energia, dentro do próton (O LHC já consegue forjar uma situação semelhante). Tais pacotes seriam o que se chama de pomerão.

Já se concebe a existência do pomerão há um bom tempo, desde antes do modelo padrão de 1973. Antigamente, no entanto, ele era visto como um possível componente fixo na atração energética interna dos prótons.

Hoje, com a teoria das cordas, a abordagem mudou. O pomerão é tido como algo criado a partir de uma colisão de partículas resultante da existência de mais de três dimensões.

6 – Leptoquark

O modelo padrão trabalha com a ideia de que o elétron tem partículas “opositoras”: lépton, múon e tau. Estas três já foram comprovadas na prática e estão incluídas no modelo padrão. O múon, mais pesado que o elétron, era tido como uma partícula “independente”, mas em 1994 um experimento na Alemanha conseguiu converter um elétron em múon a partir de colisões.

Seria preciso, portanto, uma partícula híbrida, um intermediário entre elétron e múon. Baseados no modelo padrão, que classifica o próton como um conjunto unificado de quarks, os cientistas traçaram um paralelo em que léptons são de alguma forma atraídos na formação de elétrons, e o leptoquark desempenharia um papel fundamental nesse sentido.

5 – Winos

A teoria da supersimetria, que tem sido bem aceita nos meios astrofísicos nos últimos anos, enuncia que cada partícula no universo possui uma partícula equivalente para lhe fazer oposição, geralmente com peso diferente, afim de proporcionar equilíbrio. De acordo com as teorias de interações entre partículas, existe o Bóson W (abreviatura de Weak, fraco em inglês), que trabalha com os conceitos de força forte e força fraca.

O equivalente pesado às partículas Bóson W seriam os Winos, responsáveis por proporcionar força de atração nuclear nestas situações. O LHC tem feito estudos tomando como base a teoria da supersimetria, e os Winos entram nestas suposições.

4 – Ânions

Elétrons e quarks são partículas subatômicas agrupadas em uma classe chamada de férmions, que seriam opositores dos bósons. Nas interações dimensionais entre estas duas, existiria um terceiro tipo de partícula, o ânion. Na teoria mais aceita, o ânion sempre carrega parte da energia de uma partícula subatômica durante uma interação com outra partícula, e isso seria a chave para entender algumas relações entre elas.

3 – Galileons

Einstein enunciou que a força gravitacional funciona sob o mesmo padrão em todos os pontos do universo. Dentro do sistema solar, que é até onde a ciência já pôde testar esta tese, o apontamento do físico alemão se mostrou correto. Mas, se isso é verdade, como existem as supernovas, explosões estelares que surgem justamente a partir de uma perturbação gravitacional?

A solução hipotética para este problema seriam as partículas chamadas de Galileons. De maneira geral, tratam-se partículas subatômicas originadas da formação de vácuos quânticos, que seriam responsáveis por enfraquecer a gravidade em determinados pontos do universo. O efeito destas partículas só seria sentido em regiões de baixa densidade no universo, o que não é o caso do sistema solar.

2 – Partículas Majorana

Uma partícula é geralmente idêntica à sua antipartícula, exceto por uma diferença: elas possuem cargas elétricas opostas. Em um estudo mais avançado nesse campo, o cientista italiano Ettore Majorana concebeu uma ideia aparentemente absurda: uma partícula cuja carga é zero, assim como a sua opositora, que na verdade é ela mesma. Logo, uma única partícula seria também sua antipartícula.

A concepção desta ideia ganhou força após a expansão da teoria da supersimetria, em que se defende a existência de um equivalente para cada partícula do universo. O conceito de antimatéria, por exemplo, é satisfeito com essa explicação. Dessa forma, poderiam haver vários tipos de partículas Majorana, todas tendo carga neutra e sendo a antimatéria de si mesmas.

1 – Wimpzilla

Mais de 80% da matéria existente no universo, segundo estimativas, é invisível aos nossos telescópios. Trata-se da matéria escura, objeto de estudo dos cientistas há décadas. A composição básica da matéria escura seriam as chamadas “Partículas Massivas de Interação Fraca” (WIMP, na sigla em inglês). Estas partículas, que pesariam de 10 a 100 vezes mais do que um próton, teriam surgido após o Big Bang e se espalhado paulatinamente pelo universo.

Existe, no entanto, a questão da expansão do universo a partir do início dos tempos. Durante a interação entre matéria e vácuo nesse período, algumas partículas podem ter se desprendido do fluxo da expansão em “pedaços” maiores. Seriam partículas WIMP gigantescas, bilhões de vezes mais pesadas que as originais. O nome, dado por um dos físicos que teorizou as WIMPs, faz mesmo alusão ao gigantesco monstro Godzilla. [New Scientist]

segunda-feira, 2 de abril de 2012

Chip usa luz de laser nas ligações entre os núcleos ao invés de fios.

Até 2017, a HP espera construir um chip de computador que inclui 256 microprocessadores amarrados com feixes de luz.

Com o codinome Corona, o dispositivo movido a laser lidaria com dez trilhões de operações de pontos flutuantes por segundo (FLOPS, que é uma unidade de medida que serve para mensurar a capacidade de processamento de um computador). Em outras palavras, se você colocar apenas cinco deles juntos, você se aproxima da velocidade dos supercomputadores atuais.

O chip de 256 núcleos iria se comunicar em surpreendentes 20 terabytes por segundo, com memória de 10 terabytes por segundo. Isso significa que o chip executaria aplicações de memórias intensivas cerca de duas a seis vezes mais rápido que um chip equivalente feito com fios elétricos.

O Corona também precisa de muito menos energia, ou seja, poderia lidar com 10 a 18 quintilhões de operações de pontos flutuantes por segundo. Isso é 100 vezes mais rápido que o supercomputador mais rápido de hoje.

Fotônica integrada

O chip ótico usa uma tecnologia conhecida como “fotônica integrada”. Redes de telecomunicações e computadores de alta velocidade já usam a luz para enviar informação mais rápida e eficiente.

O chip ótico usa uma tecnologia conhecida como “fotônica integrada”. Redes de telecomunicações e computadores de alta velocidade já usam a luz para enviar informação mais rápida e eficiente.

O Corona é apenas um dos vários esforços para construir chips super rápidos que podem estourar a barreira exascale, incluindo Runnemede da Intel, Angstrom do MIT, Echelon da NVIDIA, e projetos X-Calibur da Sandia. Todos procuram usar fotônica integrada, de alguma forma, mas a tecnologia é o cerne da questão para o Corona HP 256-core.

O problema é que um pouco da tecnologia necessária para construir o Corona não existe. Mas isso está mudando. Recentemente, investigadores e fabricantes de chips encolheram dispositivos ópticos de comunicações de modo que eles podem ser colocados em chips.

Há dois obstáculos que impedem a continuação da intensificação do desempenho de chips no ritmo atual: quanto mais núcleos de processadores enfiarmos em cada chip, mais desafiador é coordená-los. E, como sistemas de computadores ficam maiores, a movimentação de dados dentro e fora de memória torna-se um dreno de energia enorme.

A fotônica integrada pode ajudar com ambos os problemas, proporcionando alta velocidade de baixa potência a comunicações.

A tecnologia também pode desempenhar um papel central na promoção da largura de banda e redução do consumo de energia da internet, principalmente para suporte a serviços de vídeo.

Interferência eletromagnética também é uma preocupação crescente para dispositivos móveis e eletrônicos de automóveis. Todas essas tecnologias eventualmente vão exigir fotônica integrada.

O que falta

A peça que falta do quebra-cabeça é uma forma de gerar luz: o laser. Lasers semicondutores são amplamente utilizados em equipamentos de telecomunicações, impressoras e aparelhos de DVD. Estes lasers são similares aos chips de computador e são pequenos, mas nem de longe o suficiente para serem usados como fontes de luz para circuitos ópticos construídos em chips de computador. Para isso, você precisa fazer lasers microscópicos.

A peça que falta do quebra-cabeça é uma forma de gerar luz: o laser. Lasers semicondutores são amplamente utilizados em equipamentos de telecomunicações, impressoras e aparelhos de DVD. Estes lasers são similares aos chips de computador e são pequenos, mas nem de longe o suficiente para serem usados como fontes de luz para circuitos ópticos construídos em chips de computador. Para isso, você precisa fazer lasers microscópicos.

Não é possível fazer um laser de silício, por isso os pesquisadores tentam fazer lasers de outros materiais semicondutores, que são mais ou menos compatíveis com o padrão de chip. Estes são geralmente de fosforeto de índio ou arseneto de gálio. Esta é a abordagem que a Intel, HP e Universidade da Califórnia em Santa Barbara estão tomando.

Já o Instituto de Tecnologia de Massachusetts recentemente surgiu com uma nova abordagem: germânio. O material produz um laser que emite luz no comprimento de onda utilizado por redes de comunicações, que opera em até 120 graus Celsius e pode ser prontamente cultivado em silício.

Especialistas apontam que essa tecnologia se provar eficiente, o chip pode ser realidade até antes de 2017.[Gizmodo]

quinta-feira, 15 de março de 2012

O 'Trânsito de Vênus'.

|

| Figura 1 - Um casal vendo o trânsito em 1769 |

Em 5 de junho de 2012, você vai ver o planeta Vênus e como ele se move sobre a face do sol da manhã. Esta singularidade astronômica tem desempenhado um papel muito importante ao longo dos últimos séculos, dando aos cientistas uma maneira de entender o tamanho do sistema solar.

Há alguma evidência de que os antigos babilônios viram e registraram em um manuscrito algo sobre Vênus e o Sol no século 16 aC, mas o registro não é claro. É justo dizer que, embora Galileu da Galiléia com seu telescópio, em 1610, foi o primeiro ser humano a ver realmente Venus como mais do que apenas um ponto de luz brilhante no céu. Johannes Kepler, por sua vez, foi sacudindo o mundo com a utilização meticulosa dos dados astronômicos reunidos por Tycho Brahe. Ele previu que Vênus passaria na frente do Sol em 06 de dezembro de 1631, mas, infelizmente, o trânsito não era visível da Europa toda.

A primeira aparição registrada deste trânsito foi pelo clérigo britânico, Horrocks Jeremias, e seu amigo William Crabtree, em 04 de dezembro de 1639, só que Horrocks previu matematicamente, usando dados melhores do que Kepler.

Os cientistas descobriram que poderiam usar o trânsito para avaliar o tamanho do sistema solar! Como sabemos que a distância real do Sol à Terra é de 93 milhões de quilômetros e não, digamos, 153 milhões ou 23 milhões? Em 1663, o matemático Rev. James Gregory sugeriu que um cálculo mais preciso da distância Terra-Sol poderia ser feito durante o trânsito de Vénus. Ele acabou por ser mais difícil do que o previsto, mas durante os trânsitos subseqüentes, o foco em Vênus levou a uma descoberta ainda mais emocionante.

Durante o trânsito de 05 de junho de 1761, observado por 176 cientistas de todo o mundo, o russo Mikhail Lomonosov astrônomo (1711-1765) descobriu uma coisa muito estranha. Em vez de o disco muito negro de Vênus resvalar para borda brilhante do Sol, ele realmente cresceu um breve halo de uma bonita luz em torno de sua borda escura. Este fenômeno foi exatamente o que eles esperariam ver para saber se Vénus tinha uma atmosfera!

Em 1769, foram previstas muitas expedições internacionais de observações. A mais famosa expedição foi liderada pelo capitão James Cook, que montou um posto de observação no Tahiti com seu navio, o Endeavour. Os astrônomos da expedição, com a ajuda de um destacamento de fuzileiros navais, criaram um observatório em um ponto alto do terreno acima da baía (ainda conhecido como "Ponto de Vênus") e fizeram muitas medições de trânsito. Mais tarde, descobriu-se que na Nova Zelândia, eles ficaram presos na Grande Barreira de Corais durante várias semanas, e exploraram muitas das costas então desconhecidos da Austrália. Cook e sua tripulação completaram sua viagem ao redor da Terra e chegaram a Inglaterra com segurança e em triunfo. A expedição estabeleceu a fama de Cook como um marinheiro e explorador.

O trânsito que veio a seguir, em 6 de dezembro de 1882, apareceu nas primeiras páginas de todos os jornais nacionais e internacionais! Milhares de fotos foram tiradas com calibrações melhoradas. Apenas alguns poucos astrônomos foram de confiança para realizar os cálculos complexos a partir dos dados resultantes. Em 1896, o valor Simon Newcomb, uma distância da Terra ao Sol de 92.702.000 de mais ou menos 53,700 quilômetros, foi adotada pela comunidade científica internacional. Hoje a maioria dos livros didáticos relatam a Unidade Astronômica (UA ou) como "93 milhões de milhas."

O trânsito de Vénus tem continuado a produzir novas informações fascinantes para os cientistas e o público. Aproveite esta oportunidade única de fazer as suas próprias observações e cálculos pois a próxima será somente em 2117 !!

http://sunearthday.nasa.gov/2012/transit/transitofvenus.php

sábado, 25 de fevereiro de 2012

segunda-feira, 30 de janeiro de 2012

Gênios chapadões que mudaram o mundo.

Saiba quem são os gênios que agiam sob efeito de drogas e criaram verdadeiras revoluções na história.

Todos os dias, em todo o mundo, muitas pessoas morrem vítimas das drogas, desde as mais “leves” e lícitas (como o álcool) até as mais pesadas (como o ácido ou a cocaína). E sob o efeito de entorpecentes, poucos são aqueles que conseguem se sobressair. Você consegue se lembrar de alguém?

Nas décadas de 1960 e 1970, o consumo de drogas nos Estados Unidos foi muito elevado, sendo influenciado – e muito – pelos movimentos da contracultura. Algumas décadas antes, o uso de cocaína e maconha não era proibido, sendo inclusive recomendado por médicos e farmacêuticos.

Algumas pessoas que mudaram o mundo usavam alucinógenos e você nem sabia. Se está curioso, preste atenção neste artigo e veja quem são os principais nomes da história dos últimos séculos a terem agido sob influência das substâncias entorpecentes.

Sigmund Freud

O pai da psicanálise” foi usuário de cocaína em um período em que ela não era proibida. Inclusive, o estudioso escreveu vários tratados que alegam a eficiência da droga para fins antidepressivos e estimulantes. Por muito tempo, Freud usou a cocaína também como tratamento para problemas nasais. Ele só parou de recomendar a substância quando um amigo morreu sob efeito da droga.

O pai da psicanálise” foi usuário de cocaína em um período em que ela não era proibida. Inclusive, o estudioso escreveu vários tratados que alegam a eficiência da droga para fins antidepressivos e estimulantes. Por muito tempo, Freud usou a cocaína também como tratamento para problemas nasais. Ele só parou de recomendar a substância quando um amigo morreu sob efeito da droga.Steve Jobs

Um dos maiores gênios da computação admitiu ter utilizado LSD quando era jovem. Jobs inclusive revelou que essa foi “uma das duas ou três coisas mais importantes” que ele fez em sua vida. Foi depois disso que ele se juntou a Steve Wozniak para criar os primeiros computadores Apple e tornou-se um dos grandes nomes da informática moderna.

Bill Gates

Bill Gates é o fundador da Microsoft e idealizador do sistema operacional Windows. Ao contrário de Jobs, ele não concorda que as drogas tenham sido importantes para a vida dele. Mesmo assim, admitiu (em entrevista à Playboy, em 1994) que antes de seus 25 anos passou algum tempo sob o efeito da dietilamida de acido lisérgico (LSD).

Francis Crick

Você pode não saber quem é Francis Crick, mas tudo o que você conhece sobre a estrutura do DNA é devido aos estudos dele. Crick foi assumidamente usuário de LSD e há suspeitas de que seus tratados sobre o DNA tenham sido criados com a influência dos alucinógenos. Segundo alguns parceiros do cientista, ele só percebeu a dupla-hélice do DNA porque estava em estado alterado.

Thomas Edison

Thomas Edison é reconhecido como o criador das lâmpadas incandescentes e há muitos relatos que apontam para a relação entre o inventor e a utilização de cocaína. O cientista apoiava o consumo de um elixir de coca, que o deixava acordado por mais tempo para que pudesse criar e trabalhar. Vale lembrar que, na época, o consumo era permitido.

Benjamin Franklin

Um dos líderes da Revolução Americana (que deu origem à independência dos Estados Unidos) é também reconhecido internacionalmente pela sua relevância nos conhecimentos acerca da eletricidade e da condução elétrica. No final de sua vida, ele sofria com muitas dores por pedras nos rins e, segundo um artigo publicado na Scientific American (em 1991), ele consumia ópio para aliviar a dor.

Winston Churchill

Também conhecido como gás hilariante, o óxido nitroso é importante para fins medicinais, devido ao seu poder sedativo. Winston Churchill (Primeiro Ministro britânico durante a Segunda Guerra Mundial, peça vital para a vitória dos aliados) acabou se viciando no gás. Também há relatos de que ele se viciou em remédios para conseguir se manter calmo em reuniões importantes.

Douglas Engelbart

Reconhecido como o inventor do mouse, Douglas Engelbart assumiu publicamente que passou bom tempo de sua vida em estado alterado. Assim como Jobs e Gates, ele utilizava LSD para “despertar-se sensorialmente”. Engelbart diz que o ácido fazia com que seus pensamentos pudessem ser menos limitados.

John Lennon

Líder dos Beatles e um dos maiores nomes da contracultura, John Lennon foi muito importante para a mobilização dos jovens contrários à ocupação norte-americana no Vietnã. Há relatos de que ele tenha consumido maconha, LSD e cogumelos durante sua vida – sendo que as drogas teriam sido responsáveis por boa parte das composições dele.

Estes não 'usaram' nada !

Entre os grandes nomes da ciência, tecnologia e política que não utilizaram drogas (ou pelo menos nunca revelaram), podemos citar vários gênios. Nikola Tesla (grande rival de Thomas Edison) era conhecido por total abstinência de substâncias que pudessem alterar sua percepção da realidade (incluindo bebidas alcoólicas).

Outro destaque vai para Steve Wozniak (cofundador da Apple), que disse várias vezes em entrevistas sempre ter gostado dos hippies, mas o fato de eles usarem drogas o incomodava bastante. Também é preciso ressaltar um dos maiores gênios de toda a história: Leonardo Da Vinci, que fez todas as suas obras em estado normal.

Fonte: Tecmundo

Ilustrações: Nick Mancini

Infográfico: Diogo Saito Takeuchi

terça-feira, 17 de janeiro de 2012

Jovem de 15 anos faz Siri (iPhone 4) entender o português.

Aplicativo desenvolvido extraoficialmente mostra que é viável a tradução do novo sistema de reconhecimento de fala do iPhone 4S.

Pedro Franceschi: guarde esse nome. O jovem brasileiro de apenas 15 anos conseguiu um

feito inédito ao fazer com que o Siri, o novo assistente pessoal do iPhone 4S, entendesse

comandos em português - coisa que nem a Apple conseguiu até agora.

Para isso, não foi necessário nem mesmo efetuar o jailbreak do aparelho. PH (como é

conhecido pelos amigos) usou de bastante engenharia reversa e cálculos avançados para

chegar ao resultado final. Com o aplicativo SiriProxy, Pedro foi capaz de criar um desvio no

comando, antes que ele fosse enviado ao servidor da Apple.

Com esse desvio, ele adaptou diversas APIs para traduzir o que era falado para texto,

traduzir o texto para inglês, colocar o texto em inglês em uma API de text to speech (texto

para fala) do MAC OS X e só então enviá-lo para o servidor da Apple.

feito inédito ao fazer com que o Siri, o novo assistente pessoal do iPhone 4S, entendesse

comandos em português - coisa que nem a Apple conseguiu até agora.

Para isso, não foi necessário nem mesmo efetuar o jailbreak do aparelho. PH (como é

conhecido pelos amigos) usou de bastante engenharia reversa e cálculos avançados para

chegar ao resultado final. Com o aplicativo SiriProxy, Pedro foi capaz de criar um desvio no

comando, antes que ele fosse enviado ao servidor da Apple.

Com esse desvio, ele adaptou diversas APIs para traduzir o que era falado para texto,

traduzir o texto para inglês, colocar o texto em inglês em uma API de text to speech (texto

para fala) do MAC OS X e só então enviá-lo para o servidor da Apple.

Todo esse processo atrasa um pouco a resposta do aplicativo. Mas, como pode ser visto no

vídeo acima, o resultado é surpreendente. PH afirma que ainda não há como disponibilizar o

software para o público, mas que vai trabalhar em busca de uma solução.

vídeo acima, o resultado é surpreendente. PH afirma que ainda não há como disponibilizar o

software para o público, mas que vai trabalhar em busca de uma solução.

|

| A verdadeira utilidade das aulas de Cálculo 3 e 4. (Fonte da imagem: PedroFranceschi.com ) |

domingo, 15 de janeiro de 2012

Invente um tricorder a ganhe 10 milhões de dólares

A Qualcom e a X Prixe Foundation fizeram uma parceria para tentar desenvolver o famoso tricorder, da série de ficção Star Trek – Jornada nas Estrelas, um dispositivo móvel que pode diagnosticar pacientes em qualquer lugar de maneira rápida e eficiente. Você acha que conseguiria transformar esse equipamento ficcional em realidade? Quem conseguir isso vai receber uma bolada de nada menos do que 10 milhões de dólares.

Ganha o prêmio quem conseguir criar um tricorder que permita que qualquer pessoa possa diagnosticar com precisão o que ela tem, sem ir a um médico ou hospital, e que seja fácil e divertido de usar.

Essa é uma invenção de ficção científica que sem dúvidas seria muito útil na vida real. Mas será que o tricorder realmente existirá no futuro? Vamos ter que esperar para ver as invenções dos geeks que vão tentar ficar milionários!

6 traquitanas tecnológicas para fazer da sua casa um paraíso sem fios.

Fios são terríveis. Apesar de ser praticamente impossível fugir dos eletrônicos, nós podemos sim fugir dos cabos; pelo menos alguns deles. Aqui vão seis ferramenteas para libertar seu lar dos fios:

6 – Sistema de Som Sonos Streaming

Sonos é um sistema completo de som caseiro que vai enviar música sem fios para quantas unidades você quiser. Ele pode puxar não só da sua biblioteca virtual, mas também de vários sistemas de streaming (transmissão de dados pela internet, em tempo real). Ele também consegue enviar músicas de diferentes fontes para zonas distintas da casa. E se você tem um iPad ou iPhone, pode controlar tudo com sua mão.

Preocupado com os fios? Apenas dois. O da fonte e do áudio.

5 – Drive LG Super Multi NAS

Cansado de conectar seu computador a um HD para fazer backup? E os arquivos música e vídeo que não cabem no seu laptop? Com um drive NAS, você pode programar seu computador para fazer backup automaticamente todas as noites e passar música para seu computador ou dispositivo de áudio conectado à internet.

4 – Controle de luminosidade da GE e Z-Wave

Imagine poder controlar todas as luzes da sua casa com um controle remoto. A GE e a Z-Wave possuem uma série de produtos com essa função. Instalando um interruptor ou um registro especial, você vai poder controlar a iluminação da sua casa do sofá.

3 – Cartão de memória Secure Digital Eye-Fi X2 Wi-Fi

Passar fotos da sua câmera para o computador é sempre um trabalho chato. Ou você não encontra o cabo, ou o programa é lento e ruim, ou outro problema acontece. Um cartão como o Eye-Fi envia os arquivos para o seu computador sem cabos. Depois de ligar o Eye-Fi, o programa vai abrir no seu computador e as duas máquinas fazem o trabalho por você.

2 – Abridor de portas Lockitron

1 – Transmissor de arquivos HDMI Netgear Push2TV Wireless

Mais computadores e celulares estão chegando com a possibilidade de transmitir, sem fios, sinais de vídeo High-Definition Multimedia Interface (HDMI) – um sistema muito melhor de condução de dados do que os analógicos. O problema é que muitas TVs ainda não vêm com essa tecnologia de fábrica. O equipamento da Netgear faz com que você possa assistir o que quiser na sua TV sem ter que se preocupar com codecs, tipos de arquivo e é claro, cabos.[GizModo]

Assinar:

Postagens (Atom)